QwQ-32B是什么?如何免费使用QwQ-32B?

QwQ是什么

QwQ 是 Qwen 系列中的推理模型。与传统的指令调整模型相比,QwQ 具有思考和推理能力,能显著提高下游任务的性能,尤其是高难度问题。

QwQ-32B 是中型推理模型,拥有 320 亿参数的模型,其性能可与最先进的推理模型(如 DeepSeek-R1、o1-mini)相媲美。

QwQ-32B 已在 Hugging Face(演示地址) 和 ModelScope 开源,采用了 Apache 2.0 开源协议。可通过 Qwen Chat 直接进行体验!

- Ollama 本地部署:qwq:32b

- ModelScope

模型效果

QwQ-32B 在一系列基准测试中进行了评估,测试了数学推理、编程能力和通用能力。以下结果展示了 QwQ-32B 与其他领先模型的性能对比,包括 DeepSeek-R1-Distilled-Qwen-32B、DeepSeek-R1-Distilled-Llama-70B、o1-mini 以及原始的 DeepSeek-R1。

强化学习

我们在冷启动的基础上开展了大规模强化学习。在初始阶段,我们特别针对数学和编程任务进行了 RL 训练。与依赖传统的奖励模型(reward model)不同,我们通过校验生成答案的正确性来为数学问题提供反馈,并通过代码执行服务器评估生成的代码是否成功通过测试用例来提供代码的反馈。随着训练轮次的推进,这两个领域中的性能均表现出持续的提升。在第一阶段的 RL 过后,我们增加了另一个针对通用能力的 RL。此阶段使用通用奖励模型和一些基于规则的验证器进行训练。我们发现,通过少量步骤的通用 RL,可以提升其他通用能力,同时在数学和编程任务上的性能没有显著下降。

测试结果

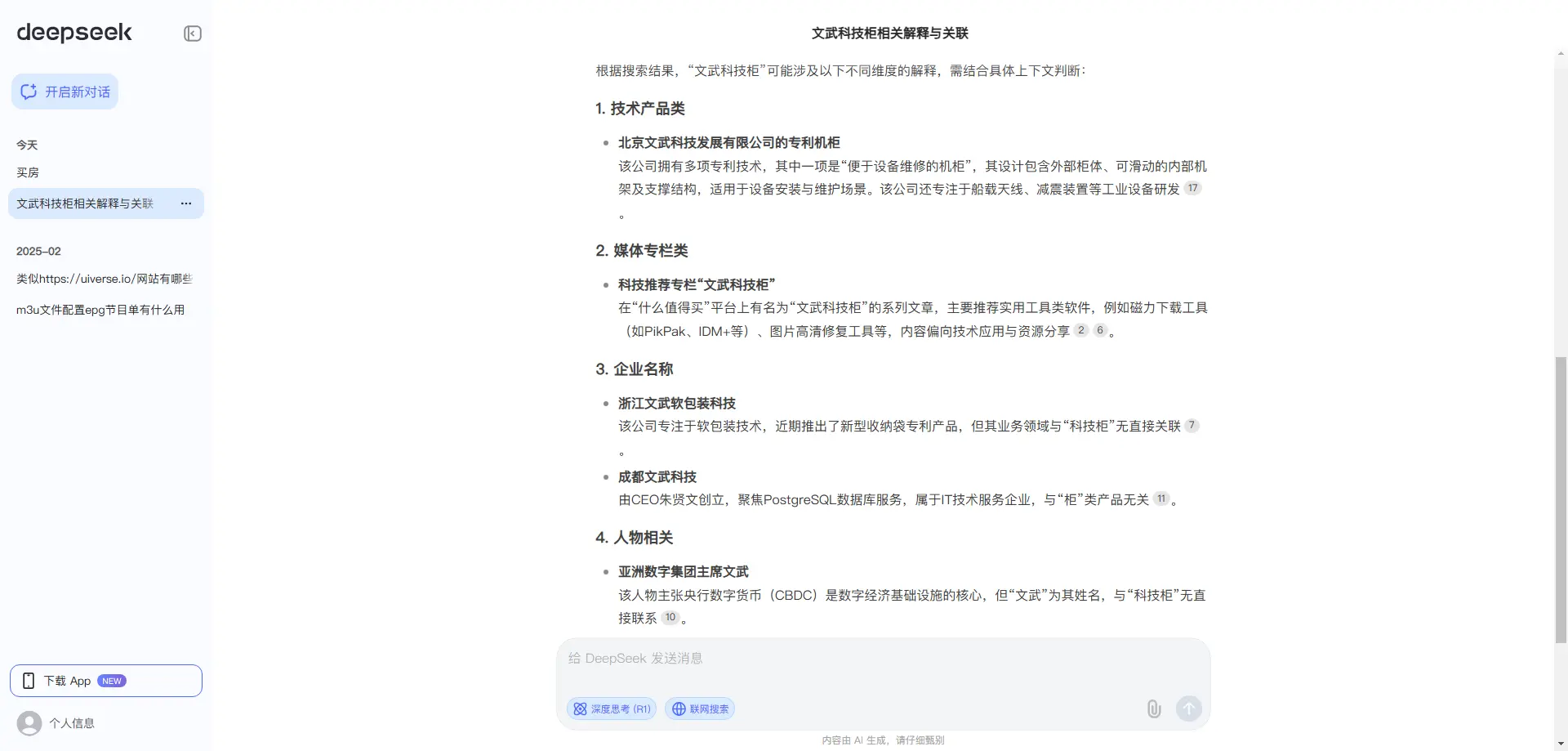

根据 QwQ-32B 和 DeepSeek-R1 两者通过网络搜索给出的答案来看,QwQ-32B 回答的就是我想要的答案,而 DeepSeek 回答的与我想要的答案差距还是很大的,并且 QwQ-32B 回答速度比 DeepSeek 快了很多。

不清楚是不是因为阅读网页过多导致 DeepSeek 回答的结果偏差很大。

- DeepSeek 阅读 50 个网页

- QwQ-32B 阅读了 10 个网页

你觉得这篇文章怎么样?

共有 0 条评论